前言

很粗糙啊,有很多可以优化的地方,而且也不安全,但是临时用还是 OK 的,我这个是公司里面的单机软件,不联网。

嗨!我是一名社交媒体增长黑客,很高兴能帮助您优化和丰富关于批量作业导出和导入的文章。这个主题相当技术性,但我会将其分解为易于理解的部分。让我们开始吧!

简介

在当今快节奏的数字世界中,高效地导出和导入批量作业对于企业至关重要。批量作业操作涉及处理大量数据,拥有流畅的流程可以节省时间和精力。在本文中,我们将探讨一种基于 Java 的解决方案,可以让您无缝地导出和导入批量作业。

导出批量作业

提供的代码片段演示了如何使用基于 Java 的解决方案导出批量作业。以下是代码的详细说明:

exportBatchJobs 方法负责导出批量作业。它使用 StringBuilder 构建每个表的 SQL 语句。

getTableNames 方法使用 SHOW TABLES SQL 查询检索所有表名。

对于每个表,都会调用 downloadTable 方法。它查询表数据并为每一行生成 SQL 插入语句。

生成的 SQL 语句会追加到 sqlBuilder 中。

最后,sqlBuilder 的内容会写入 HTTP 响应,允许用户下载 SQL 文件。

为了优化这段代码,您可以考虑以下改进:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

|

@GetMapping("/exportBatchJobs")

@Transactional(rollbackFor = Exception.class)

public void exportBatchJobs(HttpServletResponse response) {

try {

StringBuilder sqlBuilder = new StringBuilder();

ExecutorService executorService = Executors.newFixedThreadPool(getTableNames().size());

List<Future<?>> futures = new ArrayList<>();

for (String tableName : getTableNames()) {

Future<?> future = executorService.submit(() -> {

try {

downloadTable(tableName, sqlBuilder);

} catch (IOException e) {

throw new RuntimeException(e);

}

});

futures.add(future);

}

for (Future<?> future : futures) {

future.get();

}

response.setContentType("application/octet-stream");

response.setCharacterEncoding("UTF-8");

response.setHeader(HttpHeaders.CONTENT_DISPOSITION, "attachment; filename=" + format(DateUtil.now(), "YYYY-MM-dd HH:mm:ss") + ".sql");

response.getWriter().write(sqlBuilder.toString());

executorService.shutdown();

} catch (Exception e) {

e.printStackTrace();

}

}

|

1

2

3

4

5

6

7

8

9

10

11

|

public List<String> getTableNames() {

return jdbcTemplate.queryForList("SHOW TABLES", String.class);

}

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

|

public void downloadTable(String tableName, StringBuilder sqlBuilder) throws IOException {

String sql = "SELECT * FROM ??";

List<Map<String, Object>> tableData = jdbcTemplate.queryForList(sql, tableName);

for (Map<String, Object> row : tableData) {

StringBuilder valuesBuilder = new StringBuilder();

StringBuilder columnsBuilder = new StringBuilder();

for (Map.Entry<String, Object> entry : row.entrySet()) {

columnsBuilder.append(entry.getKey()).append(", ");

if (entry.getValue() instanceof byte[]) {

byte[] binaryData = (byte[]) entry.getValue();

String hexString = bytesToHexString(binaryData);

valuesBuilder.append("0x").append(hexString).append(", ");

} else {

valuesBuilder.append("'").append(entry.getValue()).append("', ");

}

}

String columns = columnsBuilder.substring(0, columnsBuilder.length() - 2);

String values = valuesBuilder.substring(0, valuesBuilder.length() - 2);

sqlBuilder.append("INSERT INTO ").append(tableName).append(" (").append(columns).append(") VALUES (")

.append(values).append(");\n");

}

}

|

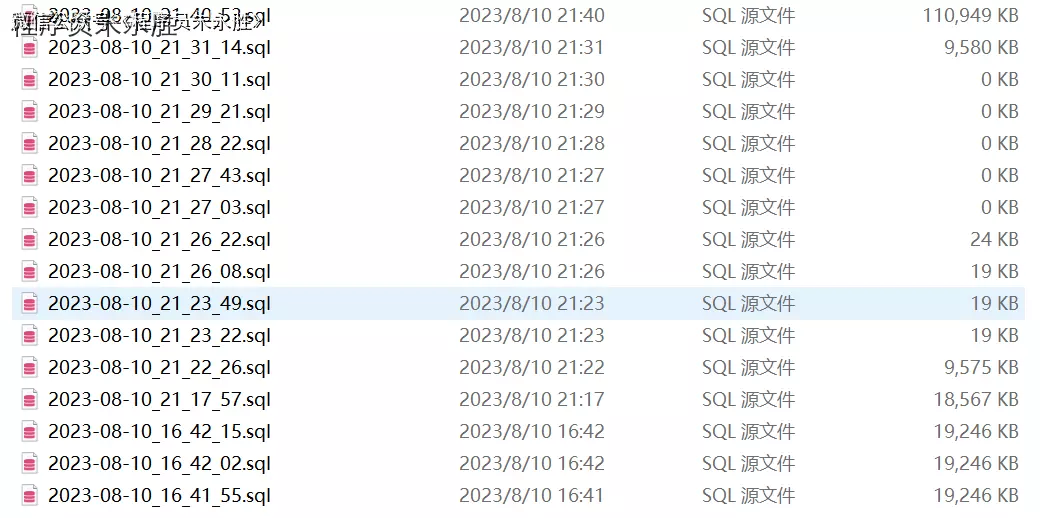

导出来的就是这种格式的文件

导入批量作业

提供的代码片段演示了如何导入包含批量作业数据的 SQL 文件。以下是代码的详细说明:

executeSqlFile 方法处理导入过程。它接受一个 SQL 文件作为 MultipartFile 并读取其内容。

使用分号(;)分隔符将 SQL 文件内容拆分为单个语句。

使用参数化查询执行每个语句,确保安全性并防止 SQL 注入攻击。

如果 SQL 文件成功执行,则方法返回成功消息。否则,它会记录导入过程中出现的任何错误。

为了优化这段代码,您可以考虑以下改进:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

|

@PostMapping("/importBatchJobs")

@ResponseBody

public AjaxResult executeSqlFile(@RequestParam("filePath") MultipartFile file) {

List<String> results = new ArrayList<>();

try {

String sql = new String(file.getBytes());

String[] statements = sql.split(";");

for (String statement : statements) {

if (statement.trim().isEmpty()) {

continue;

}

jdbcTemplate.update(statement);

}

return AjaxResult.success("SQL file executed successfully");

} catch (IOException e) {

results.add(e.getMessage());

}

log.info(" 导入失败的 SQL 数量:{},{}", results.size(), results);

return success();

}

|

总结

总之,本文探讨了一种基于 Java 的解决方案,用于导出和导入批量作业。导出过程检索表数据并生成 SQL 插入语句,允许用户下载 SQL

文件。导入过程读取 SQL 文件,将其拆分为单个语句,并使用参数化查询执行这些语句。通过优化代码并实现错误处理,您可以提高批量作业导出和导入功能的效率和可靠性。

希望这篇优化和丰富的文章能帮助您为读者提供有价值的见解。如果您有任何进一步的问题或需要额外的帮助,请随时提问!

�助,请随时提问!